详解robots.txt文件的定义与用途

在浩瀚的网络世界中,每个网站都像是一座精心构建的城堡,而搜索引擎则是那个不断探索、索引这些城堡内容的探险家。为了确保自己的城堡既能被探险家发现,又能保护其中的隐私和安全,网站管理员们使用了一种叫做robots.txt文件的神秘工具。那么,什么是robots.txt文件呢?让我们一起揭开它的神秘面纱。

robots.txt文件,简单来说,就是一个放置在网站根目录下的纯文本文件。它的主要作用是告诉搜索引擎的爬虫(也称为蜘蛛或机器人)哪些页面可以被访问和索引,哪些页面则不应该被访问。这个文件的命名非常固定,必须是“robots.txt”,而且必须放在网站的根目录下,这样当搜索引擎的爬虫访问网站时,它会首先查找这个文件,然后根据文件中的指示来决定接下来的行动。

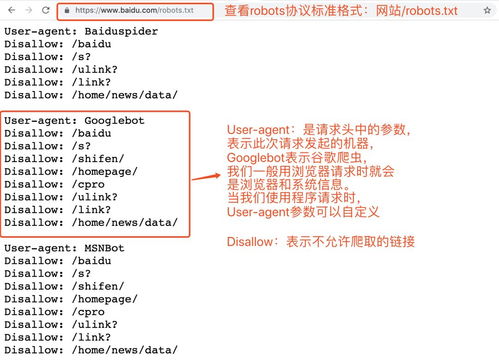

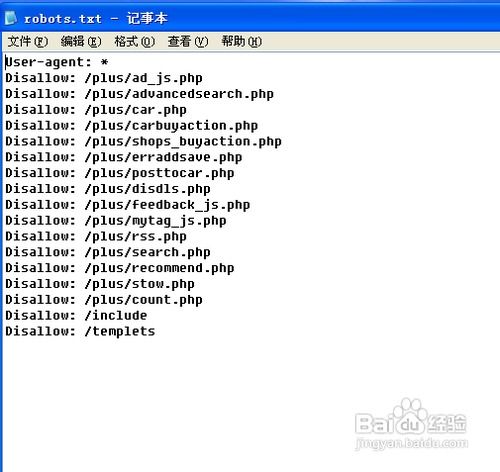

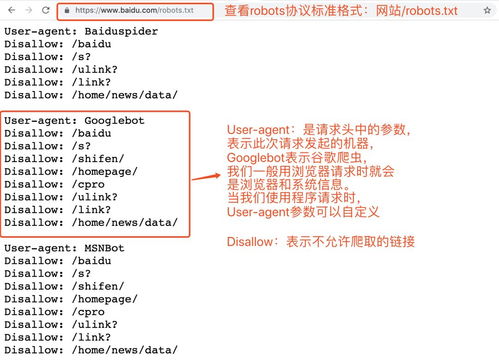

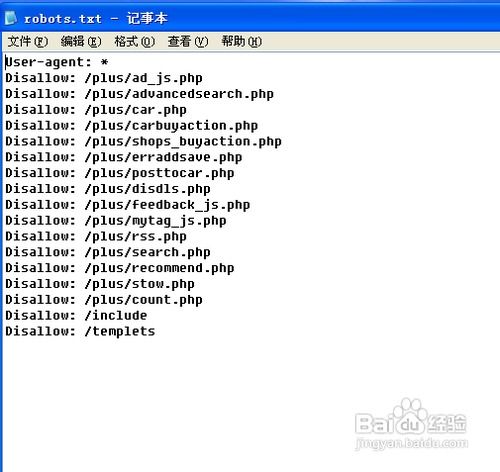

robots.txt文件的格式并不复杂,它由一系列的指令组成,每个指令占一行。这些指令主要分为两大类:User-agent和Disallow(或Allow)。User-agent指定了爬虫的名称或标识符,比如“*”代表适用于所有爬虫,“Googlebot”则仅代表适用于Google的爬虫。Disallow指令后面跟着的是不允许访问的页面或目录的路径,而Allow指令则指定了允许访问的路径。这些指令帮助网站管理员精确地控制爬虫的行为,保护网站的重要信息不被泄露,同时避免无效的爬取和资源浪费。

那么,robots.txt文件具体有哪些作用呢?

首先,robots.txt文件是保护网站隐私和安全的重要工具。通过指定不允许爬取的页面,网站管理员可以防止敏感信息被搜索引擎收录,从而保护网站的安全。比如,网站的后台管理页面、用户数据页面等,通常都不希望被搜索引擎爬虫访问和索引。

其次,robots.txt文件还可以控制搜索引擎爬虫的抓取频率。如果爬虫过于频繁地访问网站,可能会对网站服务器造成过大的压力,影响网站的正常运行。通过在robots.txt文件中设置合理的抓取频率限制(虽然robots.txt本身没有直接的Crawl-delay参数,但某些搜索引擎会尊重通过其他方式设置的抓取间隔),网站管理员可以确保爬虫在不影响网站性能的前提下进行抓取。

此外,robots.txt文件还能指导搜索引擎爬虫爬取网站的特定部分。通过允许爬虫访问某些页面,网站管理员可以帮助搜索引擎更好地理解网站的结构和内容,从而提高网站在搜索结果中的排名。这对于网站的SEO优化来说至关重要。

在编写robots.txt文件时,需要遵循一些基本的规则。首先,文件必须命名为robots.txt,并放置在网站的根目录下。其次,文件应为纯文本格式,并使用UTF-8编码,以确保不同系统下的兼容性。在文件中,可以使用符号添加注释,这些注释不会被搜索引擎解析。同时,每个指令之间应留有空行,以提高可读性。在编写指令时,需要注意区分大小写,因为搜索引擎爬虫对大小写是敏感的。

在实际应用中,创建robots.txt文件通常包括以下几个步骤:首先,确定你想要保护的网站目录和页面;其次,了解不同搜索引擎的爬虫名称;然后,在网站根目录下创建一个名为robots.txt的文件;最后,在文件中根据需求编写User-agent、Disallow和Allow等指令。

然而,值得注意的是,robots.txt文件只是一种建议,而不是强制性的规则。虽然大多数搜索引擎爬虫会遵守robots.txt文件的指示,但也有一些爬虫可能会选择忽略它。因此,对于真正需要保护的敏感信息,网站管理员还需要采取其他安全措施,如密码保护、IP限制等。

此外,robots.txt文件还可以用来指定网站的XML Sitemap文件的URL路径。Sitemap是一个包含了网站上所有链接的列表的文件,它可以帮助搜索引擎更快地发现和索引网站的内容。通过在robots.txt文件中指定Sitemap的URL,网站管理员可以引导搜索引擎爬虫更有效地爬取和索引网站的内容。

在编写robots.txt文件时,还需要注意避免一些常见的问题。比如,文件的位置和命名不正确、权限设置不当、规则书写错误等,都可能导致robots.txt文件无法被搜索引擎正确解析和执行。为了解决这些问题,网站管理员需要仔细检查文件的位置、命名、权限设置和规则书写是否正确,并可以使用搜索引擎工具或在线验证工具来验证robots.txt文件的有效性。

总的来说,robots.txt文件是网站管理者与搜索引擎之间沟通的桥梁。它通过提供明确的指示,帮助搜索引擎爬虫更有效地爬取和索引网站的内容,同时保护网站的隐私和安全。对于网站管理员来说,了解和正确使用robots.txt文件是优化和管理网站的重要一环。通过合理编写robots.txt文件,网站管理员可以控制搜索引擎爬虫的访问范围,提高网站的可见性和排名,为网站带来更多的流量和机会。

在数字化时代,每个网站都是一个展示自己品牌和内容的窗口。而robots.txt文件就像是这个窗口的守护者,它默默地守护着网站的隐私和安全,引导着搜索引擎爬虫在网站中高效地穿梭。只有当我们充分理解和利用robots.txt文件的功能时,我们才能更好地管理和优化自己的网站,让它在网络世界中焕发出更加耀眼的光芒。

- 上一篇: 解锁养花秘籍:轻松成为花卉养护达人

- 下一篇: 新手必看:掌握十字绣技巧的独家秘诀,轻松绣出精美作品

-

深入理解Robots协议资讯攻略11-03

深入理解Robots协议资讯攻略11-03 -

解析robot.txt的作用、用途及编写方法资讯攻略11-27

解析robot.txt的作用、用途及编写方法资讯攻略11-27 -

MDB文件详解:用途、定义及打开方法资讯攻略04-05

MDB文件详解:用途、定义及打开方法资讯攻略04-05 -

哇嘎的定义及用途是什么资讯攻略11-10

哇嘎的定义及用途是什么资讯攻略11-10 -

电子信箱的定义与用途资讯攻略01-05

电子信箱的定义与用途资讯攻略01-05 -

乌木:详解与定义资讯攻略12-08

乌木:详解与定义资讯攻略12-08